Охватившие Великобританию погромы в этом августе были вызваны распространением в соцсетях фейка, который связывают с Кремлем. Среди причин онлайн-травли алжирской боксерки Иман Хелиф во время Олимпиады в Париже также называют российское влияние. В период активной фазы выборов в Европарламент таких примеров российской дезинформации насчитывались сотни.

При этом в последние годы инструменты информационного влияния Кремля развиваются вместе с прогрессом технологий. Теперь в арсенал входят дипфейки, подделка голоса и другие производные искусственного интеллекта.

Какие из последних выборов в Европе оказались под дезинформационным ударом Москвы и почему за запрет использования ИИ для политических целей теперь выступают и ультраправые политики, специально для «Новой-Европа» разбирался политолог Игорь Мыглан.

День тишины

— Кто-то вновь закинет бюллетени прямо в урны?

— На этот счет не переживай, всё уже решили.

— А я правда получу хорошую награду за участие в этом, как договаривались? Или какой план?

— Каждый получит награду за участие. О сумме и таком способе передачи денег, чтобы тебя никто не обвинил в подкупе, мы позаботимся…

Двухминутная аудиозапись с таким диалогом распространилась по соцсетям 28 сентября 2023 года, за два дня до парламентских выборов в Словакии. Вопросы якобы задает словацкая журналистка Моника Тодова, отвечает лидер либеральной партии «Прогрессивная Словакия» Михал Шимечка. Помимо процедуры вброса и вознаграждения за участие в фальсификации собеседники обсуждают, как обеспечить на предстоящих выборах скупку голосов представителей народа рома — одного из этнических меньшинств в Словакии.

Лидер партии «Прогрессивная Словакия» и лидер оппозиции Михал Шимечка голосует на избирательном участке во время парламентских выборов в Братиславе, Словакия, 30 сентября 2023 года. Фото: Martin Divisek / EPA-EFE

Несмотря на официальный запрет на агитацию в стране в «дни тишины» — меньше чем за 48 часов до выборов, аудио быстро разошлось по социальным сетям, включая Telegram и Facebook. И хотя Тодова и Шимечка сразу же заявили о том, что запись фейковая, полиция отказалась проводить расследование, поскольку «общественность не была бы введена в заблуждение такого рода поддельным аудио». Лишь через полгода после выборов, в феврале 2024-го, прокурор постановил начать проверку.

Между тем фейк, по всей видимости, оказал влияние на предпочтения избирателей, увеличив отрыв партии «Курс — социальная демократия» (SMER) под председательством известного своими пророссийскими взглядами Роберта Фицо от «Прогрессивной Словакии». Если по опросам 27 сентября разница составляла 3% (при 18% готовых голосовать за «Прогрессивную Словакию» и 21% — за SMER), то уже 30 сентября она дошла до 5% (18% у прогрессистов и 23% у партии Фицо).

По итогам выборов прогрессисты уступили Фицо с незначительным разрывом: 22,95% у SMER против 17,96% у партии Шимечки. Фицо вернулся в кресло премьера Словакии, начав свое правление с резонансных сообщений об «использовании» Украины Западом для ослабления России.

Директор связанного с МВД Словакии Центра по борьбе с гибридными угрозами Даниэль Мило заявил, что распространение такого фейка совпадает с интересами России и могло быть организовано российскими агентами.

В ответ глава Службы внешней разведки РФ Сергей Нарышкин сказал, что это США поручили своим европейским союзникам использовать «давление, шантаж, запугивание и взяточничество», чтобы обеспечить победу «Прогрессивной Словакии» на выборах. Вслед за этим заявлением МИД Словакии вызвал российского посла Игоря Братчикова, прямо обвинив Россию во вмешательстве в выборы. Россия все обвинения отвергла.

Первая фейковая

В июне этого года, накануне выборов в Европарламент, команда StratCom — оперативная группа, созданная в 2015 году и занимающаяся борьбой с дезинформацией в Европе под началом главы МИД ЕС, — заявила, что Россия уже несколько месяцев проводит кампанию по дезинформации. Причем практика эта не новая, но в этот раз отличается гораздо большей вариативностью фейков.

История информационных атак России на выборы с использованием всего доступного инструментария — от ботов в соцсетях до взломов баз избирателей — началась еще с выборов в США в 2016 году. Тогда была проведена масштабная кампания, включавшая взлом компьютерных систем Демократического национального комитета (DNC) и штаба кампании Хиллари Клинтон. Опубликованные после этого документы ударили по рейтингу кандидата от демократов и, по замыслу, должны были подорвать доверие к выборам в целом. В меньшем объеме атака была проведена в Британии в ходе референдума по выходу страны из ЕС.

В континентальной Европе первой крупной зафиксированной попыткой влияния на результаты голосования через внешние информационные каналы стали предыдущие выборы в Европарламент в 2019 году. Рабочей группе по стратегическим коммуникациям удалось доказать 998 случаев дезинформации со стороны России в первой половине предвыборного 2019 года. Как заявили в Еврокомиссии, собранные свидетельства не позволяют говорить об «отчетливой» кампании по дезинформации, тем не менее были сделаны выводы о «непрерывающейся деятельности по дезинформации (со стороны России), направленной на подавление явки и влияние на предпочтения избирателей».

Никола Дзингаретти на пресс-конференции Демократической партии Италии, Рим, 21 сентября 2020 года. Фото: Angelo Carconi / EPA-EFE

Наиболее известные случаи фейков в ходе выборов 2019 года касались вопросов миграции — проблемы, на которой часто набирали голоса правые популисты. Например, в соцсети Twitter под хэштегом#euelections2019 распространялось видео, на котором мужчина — выходец из арабских стран ломает статую женщины. Подпись гласила: «Мусульманский иммигрант уничтожает статую в Италии». На деле это оказалось видео протестов в Алжире, снятое в 2017-м. В некоторых постах утверждалось, что показана статуя Девы Марии, но, как сообщило новостное агентство AFP, в реальности это была скульптура наяды — существа из древнегреческой мифологии. Тем не менее, несмотря на опровержения, в одной только соцсети Facebook видео набрало 2,7 млн просмотров.

Кроме того, там же распространялись поддельные фото избирательных бюллетеней кандидата от итальянской Демократической партии Николы Дзингаретти, сообщающего о готовности впустить в ЕС 800 тыс. ливийских беженцев. Итальянская полиция, однако, подтвердила, что политик никогда не делал подобных заявлений.

По словам команды StratCom, на выборах в Европарламент в 2024 году Россией также были использованы уже опробованные ранее тиражирование теорий заговора и распространение фальшивых новостей, в том числе через обширную сеть ботов в соцсетях.

По данным проекта Maldita, в ходе предвыборной кампании в 26 европейских странах был выявлен 1321 пост с фейковой информацией. 20 самых вирусных постов, не удаленных платформами, набрали более 1,5 млн просмотров каждый. Основные темы дезинформации касались миграции, честности выборов, войны в Украине, войны в Газе и пандемии.

Однако, как утверждают представители StratCom, теперь в арсенале Кремля есть и более изощренные методы, появившиеся в результате развития искусственного интеллекта, который позволяет производить правдоподобный контент в промышленном масштабе.

Учения НАТО Nordic Response в Финляндии, 5 марта 2024 года. Фото: Anders Wiklund / EPA-EFE

Трудности перевода

Вступление Финляндии в НАТО в апреле 2023 года, хронологически совпавшее с парламентскими выборами в стране, судя по всему, также активизировало российских троллей, пытавшихся показать недовольство «простых финнов» изменившимся курсом страны. Но, в отличие от вмешательства в словацкие выборы, в ходе финской кампании, проходившей на полгода раньше, использовался куда более скромный арсенал методов.

Так, в феврале 2023-го в соцсети Twitter начал массово распространяться пост якобы финского пользователя под ником Uolevi Alto со словами: «NATO ei voi tallentaa Suomea» (НАТО не может сохранить Финляндию). Однако, похоже, эта фраза была переведена иностранным пользователем с помощью онлайн-переводчика, не справившегося со смысловыми оттенками. В финском языке есть два слова со значением «сохранить»: tallentaa (в смысле записи или хранения, например, документа) и pelastaa (в смысле спасения). В итоге твит набрал всего несколько десятков тысяч просмотров и меньше десяти лайков.

Помимо подобных «неуклюжих» ботов, в той же соцсети Twitter было распространено искаженное искусственным интеллектом выступление на тот момент премьер-министра Финляндии Санны Марин. В нем она якобы призывала Финляндию к войне против России.

Однако эта приписываемая Кремлю информационная кампания оказалась безрезультатной как в отношении парламентских выборов, так и настроений финнов по поводу вступления страны в НАТО.

Рейтинг Социал-демократической партии Санны Марин в феврале 2023 года не претерпел изменений, а сами выборы ее партия проиграла по внутренним причинам, а не из-за внешнего влияния. На протяжении большей части 2023 года поддержка финнами идеи вступления в НАТО сохранялась на уровне 70%.

Комментариев относительно чьей-либо причастности со стороны официальных лиц ни Финляндии, ни России, в отличие от случая в Словакии, не последовало. Но, по оценке сотрудницы Финского института международных отношений Минны Аландер, это была «очень слабая попытка вмешаться в выборы со стороны Кремля с помощью троллей и ботов, которые делали смешные ошибки в финском языке».

Комиссары наносят ответный удар

Весной 2021 года Еврокомиссия начала разрабатывать закон, регулирующий использование искусственного интеллекта (ИИ) на территории ЕС. Ключевым изменением, на котором настаивал Брюссель, стало внедрение шкалы оценки риска при развитии и использовании любых технологий ИИ. Шкала включала четыре уровня: неприемлемый, высокий, ограниченный и минимальный.

Политический контент, создаваемый ИИ, был оценен как несущий высокий (таргетированная политическая реклама) и ограниченный (чат-боты) риски. Это значит, что их использование не запрещено полностью, но для получения одобрения на разработку нужно пройти сложную оценку соответствия стандартам защиты от угроз.

Однако реакция европейских чиновников пока что с трудом поспевает за развитием технологий и не может ни остановить использование ИИ в предвыборных кампаниях, ни предотвратить появление новых методов дезинформации. В числе последних, в том числе опробованных Россией в ходе подготовки к выборам в Европарламент, — доппельгангеры и дипфейки.

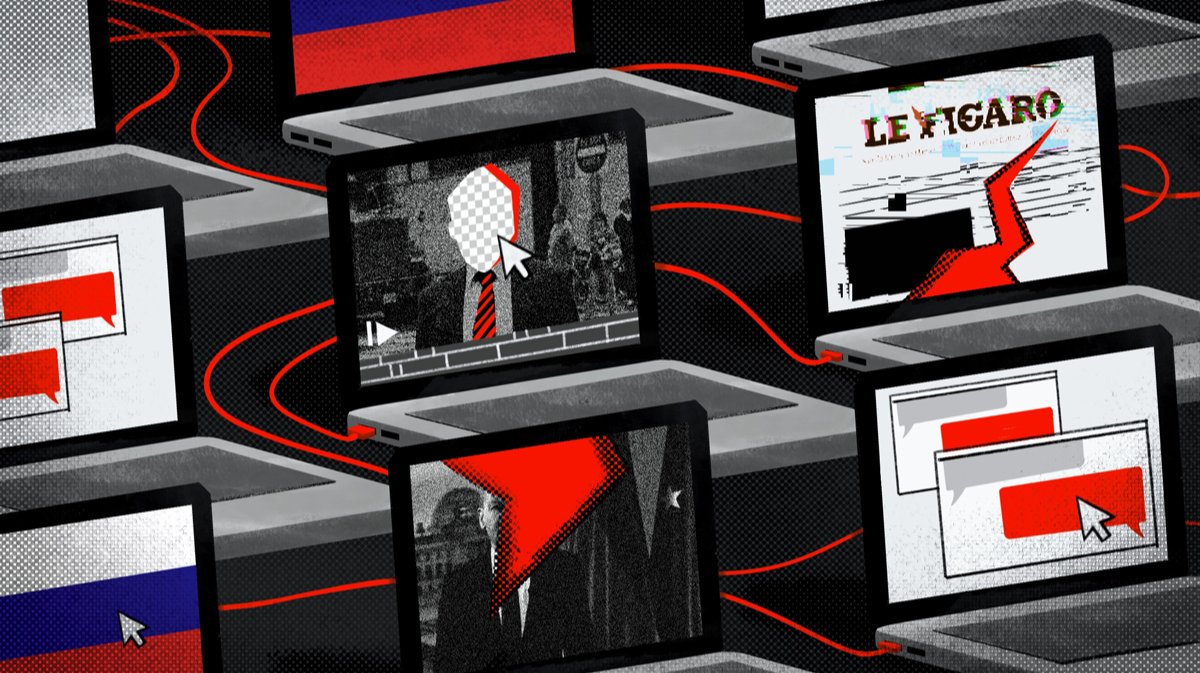

Доппельгангеры — поддельные веб-сайты, по виду идентичные реальным источникам информации и почти не отличающиеся по доменному имени. Как писала ранее «Новая-Европа», фейковые близнецы летом 2023 года появились, например, у сайтов Le Figaro и Le Monde — на них было опубликовано 49 поддельных статей на тему войны в Украине и ее последствий. Постили их специально созданные сети ботов в Facebook и X. Аналогичная участь постигла в прошлом году и немецкие издания, а также сайт МВД Германии: на нем разместили поддельный пресс-релиз об обязанности немецких граждан принимать у себя украинских беженцев.

Дипфейки — реалистичный контент, созданный искусственным интеллектом. Он может варьировать от поддельного аудио или телефонного звонка до всё более реалистичных изображений или видео. Именно дипфейком и оказался подделанный с помощью нейросети телефонный разговор лидера партии «Прогрессивная Словакия» Михала Шимечки c журналисткой Моникой Тодовой.

Фейки против демократии

В конце мая 2024 на сайте национального новостного агентства Польши появилась новость о том, что 1 июля премьер-министр Дональд Туск планирует провести в Польше частичную мобилизацию. «Двести тысяч польских граждан, как бывших военных, так и обычных гражданских лиц, будут призваны на обязательную военную службу. Все мобилизованные будут отправлены в Украину», — было сказано в материале.

Фейковая новость была быстро удалена, но хакеры повторили атаку, и сообщение появилось в сети снова. Власти Польши прямо заявили о причастности к атаке российских хакеров.

Дональд Туск во время посещения военной базы США в Ясёнке, Польша, 1 июля 2024 года. Фото: Darek Delmanowicz / EPA-EFE

Несмотря на то что с начала полномасштабной войны такие вбросы стали едва ли не повседневностью, премьер Польши Дональд Туск отметил, что это была «очень опасная хакерская атака», иллюстрирующая «стратегию дестабилизации России перед выборами». Его заместитель по цифровому развитию Кшиштоф Гавковски также высказал мнение, что цель вброса — «дезинформация в преддверии выборов [в Европарламент] и паралич общества».

В своем заявлении представители StratCom акцентировали внимание на том, что

всплеск дезинформации накануне общеевропейского дня голосования — лишь часть более широкой кампании со стороны России, направленной на подрыв доверия к национальным правительствам стран ЕС и выборным процедурам в целом.

«Хотим ли мы видеть сильную Европу, которая борется за наши ценности и нашу демократию? Или же мы позволим захватить демократию марионеткам автократий?» — поддержала эту же точку зрения председатель Еврокомиссии Урсула фон дер Ляйен.

Однако дипфейки, фальшивые новости и другие методы дезинформации приобрели такую популярность во время избирательных кампаний, что теперь используются далеко не только авторитарными режимами против демократий.

Фейковые премьеры и племянницы

В августе 2023 года, за несколько недель до парламентских выборов в Польше, оппозиционная партия «Гражданская платформа», руководимая всё тем же Дональдом Туском, выложила в своих соцсетях выступление премьер-министра Матеуша Моравецкого, члена правящей на тот момент в Польше партии «Право и справедливость».

«Они называют себя объединенными правыми. Но вы, наверное, знаете, кто они на самом деле. А что вы думаете о премьер-министре?» — такими словами начиналось видео. Далее чередовались отрывки подлинных выступлений Моравецкого и сгенерированные аудио с голосом польского премьера, который зачитывал фрагменты писем из взломанной почты бывшего начальника штаба премьера Михала Дворчика. «Наша коалиция тверда как сталь», — публично заявлял премьер. При этом из зачитанных писем становилось понятно, что между ним и министром юстиции Збигневом Зеброй, лидером правой партии «Суверенная Польша» и наиболее значимым союзником «Права и справедливости» на предстоящих выборах, есть конфликт.

Матеуш Моравецкий выступает во время встречи представителей правящей партии «Право и справедливость» (PiS) с местными жителями в Рыбнике, Польша, 12 октября 2023 года. Фото: Radek Pietruszka / EPA-EFE

В самом видео, выложенном оппозицией, не упоминалось, что голос, зачитывающий письма, создан с помощью искусственного интеллекта. Эта информация была включена в пост лишь спустя несколько часов после публикации под давлением критики в соцсетях. Никаких юридических последствий для авторов фейк не имел, впрочем, как и заметного влияния на общественное мнение. Рейтинги как «Гражданской платформы», так и правящей партии после скандала почти не изменились.

Тем не менее по итогам выборов «Право и справедливость» проиграла демократической коалиции Польши, куда входила «Гражданская платформа» Туска.

Однако победу польской оппозиции омрачило использование дипфейка в ходе кампании. Пожалуй, это первый случай, когда мейнстримные проевропейские силы прибегли к такой технологии.

В ноябре 2023 года жертвой дипфейка стала немецкая ультраправая партия «Альтернатива для Германии» (AfD), известная своей прокремлевской позицией. В соцсетях было опубликовано выступление канцлера Олафа Шольца, который объявляет о запрете AfD и просит граждан помочь в сборе доказательств антиконституционных преступлений партии. Суд Берлина постановил удалить видео, мотивировав это в том числе тем, что «голос и манера федерального канцлера имитировались с почти пугающим качеством» и для обычного зрителя было не очевидно, что это не подлинная речь.

Дипфейк с Шольцем оказался произведением независимой левой ассоциации художников Zentrum für Politische Schönheit (дословно: Центр политической красоты), выступающих против расизма и антисемитизма. Сама группа называет себя «радикальными гуманистами», идущими против экстремизма, — видео стало частью их запущенной в том же 2023 году кампании за запрет в Германии «Альтернативы для Германии».

Несмотря на то что видео не имело прямых политических последствий, оно активизировало дискуссию об ограничениях на использование искусственного интеллекта в политической рекламе в преддверии выборов в Европарламент. «Такие дипфейки — это не весело», — заявил представитель немецкого правительства Штефан Хебестрайт. А эксперт по кибербезопасности из Института Фраунгофера (Fraunhofer AISEC) Николас Мюллер предложил пойти дальше и маркировать водяным знаком любой реальный, а не сгенерированный ИИ политический контент.

Олаф Шольц. Фото: Hannibal Hanschke / EPA-EFE

Наконец, в апреле 2024 года дипфейки добрались и до лидера ультраправого «Национального собрания» во Франции Марин Ле Пен. «Это платье, которое я надену для победы Жордана Барделла», — говорит в поддельном видео в TikTok одна из никогда не существовавших «племянниц» Ле Пен. «Мохамед — это парень, который оскорбляет «Национальное собрание», но пишет мне в личку», — якобы рассказывает другая.

После появления видео семья Ле Пен выразила недовольство, а партия «Национальное движение» подала жалобу в TikTok. Но несмотря на усилия по удалению видео, фейки быстро стали вирусными и набрали более 2 млн просмотров.

Марин Ле Пен и Жордан Барделла. Фото: Thomas Padilla / AP Photo / Scanpix / LETA

«Эти фейки не имели политической направленности. Рассматривайте это как социальный эксперимент, демонстрирующий опасность дезинформации», — рассказал в интервью каналу BFMTV человек, представившийся как автор поддельных аккаунтов племянниц Ле Пен.

Ирония заключается в том, что представители «Национального собрания» неоднократно выступали против европейских инициатив по регулированию дипфейков. Однако перед выборами в Европарламент, когда партия сама стала жертвой ИИ, ее руководитель Жордан Барделла резко изменил свою позицию.

Фейки никак не повлияли на электоральный расклад: 10 апреля за «Национальное собрание» были готовы отдать свои голоса 31%, 25 апреля — 32%. Тем не менее Барделла выступил за ужесточение регулирования контента, созданного ИИ.

Изменение позиции лидеров французских ультраправых по вопросу регулирования ИИ демонстрирует то, какой путь проделали эти технологии на европейской политической сцене. Теперь дипфейки и доппельгангеры используются уже не только как инструмент внешнего вмешательства и подрыва демократий, за которым можно увидеть руку диктатур, в том числе России, но и как средство внутриполитической борьбы в ЕС. Использование ИИ в политике нормализуется — причем не только против мейнстримных сил, но и против тех, кто ранее сам прибегал к этому методу, — популистов.

Делайте «Новую» вместе с нами!

В России введена военная цензура. Независимая журналистика под запретом. В этих условиях делать расследования из России и о России становится не просто сложнее, но и опаснее. Но мы продолжаем работу, потому что знаем, что наши читатели остаются свободными людьми. «Новая газета Европа» отчитывается только перед вами и зависит только от вас. Помогите нам оставаться антидотом от диктатуры — поддержите нас деньгами.

Нажимая кнопку «Поддержать», вы соглашаетесь с правилами обработки персональных данных.

Если вы захотите отписаться от регулярного пожертвования, напишите нам на почту: [email protected]

Если вы находитесь в России или имеете российское гражданство и собираетесь посещать страну, законы запрещают вам делать пожертвования «Новой-Европа».