Нобелевский комитет 8 октября вручил премию по физике. Ее лауреатами стали Джон Дж. Хопфилд из Принстонского университета в США и Джеффри Э. Хинтон из Университета Торонто в Канаде. Ученые удостоились награды за вклад в «основополагающие открытия и изобретения, обеспечивающие машинное обучение с помощью искусственных нейронных сетей». Оба лауреата занимались статистической физикой, и их многолетняя работа привела к появлению нейросетей. «Хотя компьютеры не могут думать, теперь они могут имитировать такие функции, как память и обучение. Лауреаты этого года по физике помогли сделать подобное возможным», — говорится в заявлении Нобелевского комитета.

Машинное обучение и работа мозга

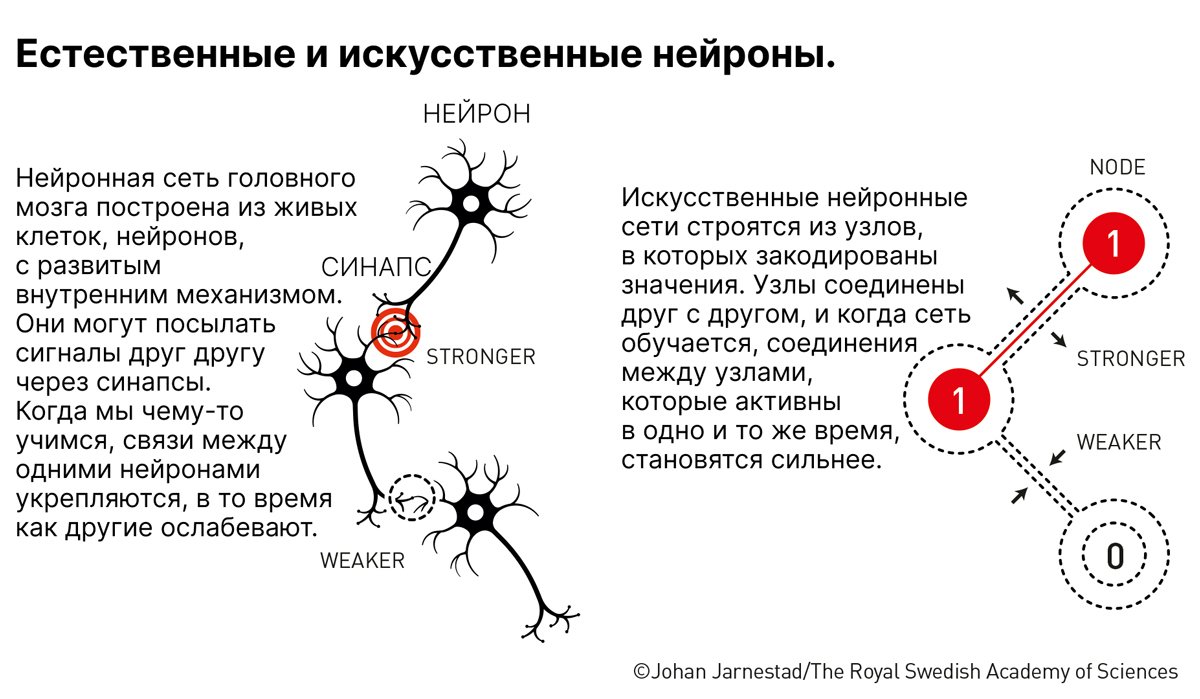

Еще в 1943 году нейробиолог Уоррен Маккалок и математик Уолтер Питтс предложили модель взаимодействия нейронов мозга. В ней нейрон формировал взвешенную сумму двоичных сигналов, поступающих от соседних, которая и определялась как исходящий сигнал. Их работа стала стартовой площадкой для дальнейших исследований искусственных нейронных сетей. Еще один вклад принадлежит психологу Дональду Хеббу. В 1949 году он предложил механизм обучения и памяти, в котором одновременное и повторяющееся активация двух нейронов приводит к укреплению связи между ними. Именно эти две работы и подтолкнули других исследователей к тому, чтобы применить понятия из биологии к разработке методов машинного обучения.

Машинное обучение — это один из методов искусственного интеллекта, принцип которого заключается в том, чтобы создавать компьютеры и программы, способные думать подобно человеку. Однако, в отличие от человеческого мозга, этот метод позволяет обрабатывать огромные массивы данных, чтобы находить в них закономерности и строить прогнозы. Приложения машинного обучения формируются с помощью сложного алгоритма или исходного кода, встроенного в машину или компьютер. Этот программный код создает модель, которая идентифицирует данные и строит прогнозы на их основе. Модель использует параметры, встроенные в алгоритм, для формирования шаблонов процесса принятия решений. Когда становятся доступными новые или дополнительные данные, алгоритм автоматически корректирует параметры. Однако сама модель при этом меняться не должна.

Нейросети же представляют собой один из видов машинного обучения, когда компьютерная программа имитирует работу человеческого мозга. Подобно тому, как нейроны в мозге передают сигналы друг другу, в нейросети информацией обмениваются вычислительные элементы.

Таким образом, искусственные нейроны имитируют работу человеческих, взаимодействуя для решения задачи.

Важным параметром любой нейросети являются веса или значения, которые отражают важность связей между теми или иными нейронами. Перед обучением нейронной сети эти веса изначально задаются случайными значениями, но в процессе они постоянно корректируются до тех пор, пока данные обучения не будут постоянно выдавать одинаковые результаты.

Сравнение работы мозга и нейросети / nobelprize.org

Ассоциативная память машин

В 1980 году Хопфилд оставил занятия физикой в Принстонском университете и принял предложение стать профессором химии и биологии в Калифорнийском технологическом институте в Калифорнии. Там в 1982 году он создал первую ассоциативную нейросеть, которая работает подобно ассоциативной памяти человека. Он использовал свойство памяти, которое позволяет людям достраивать образы при нехватке данных о них благодаря ассоциациям. По сути, это модель, которая хранит и способна воссоздавать изображения и другие типы шаблонов. Хопфилд опирался на теорию обучения нейробиолога Дональда Хебба о том, что связи между нейронами укрепляются, когда они работают вместе.

Хопфилд описал модель содержательно-адресуемой памяти, которая обращается к ее содержимому, используя алгоритм асинхронной параллельной обработки данных. Он использовал свои познания в физике, в частности, о магнитных материалах. Они обладают особыми характеристиками благодаря своему атомному спину — свойству, которое делает каждый атом крошечным магнитом. Спины соседних атомов влияют друг на друга, что позволяет им вращаться в одном и том же направлении.

Профессор Андерс Ирбак на пресс-конференции в Шведской королевской академии наук после объявления лауреатов Нобелевской премии по физике за 2024 год, Стокгольм, 8 октября 2024 года. Фото: Christine Olsson / EPA-EFE

Сеть, построенная Хопфилдом, состоит из узлов с соединениями (весами) разных типов. Каждый узел может хранить индивидуальное значение — либо 0, либо 1, подобно пикселям на черно-белом изображении. Она обучается путем последовательного вычисления значений весов, чтобы прийти к состоянию равновесия. Это значение определяется неким эквивалентом физической «энергии», который зависит от всех весов в системе. Сеть обучается путем поиска минимума «энергии», при котором она «запомнила» определенный шаблон. Если при прохождении узла это значение уменьшается, то черный пиксель становится белым или наоборот. Когда цель достигнута, сеть воспроизводил исходное изображение, на котором ее обучали. Если образ немного исказить и подать на вход сети, то он тоже будет восстановлен.

Такую нейросеть можно отнести к автоассоциативной памяти, то есть такой, которая может завершить или исправить образ, но не может ассоциировать его с другим.

Как работает ассоциативная память / nobelprize.org

Она также способна к обобщению, распознаванию похожих образов, их категоризации и исправлению ошибок.

В наши дни нейросети Хопфилда относят к типу рекуррентных, которые перенаправляют информацию туда и обратно по слоям, пока не получат конечный результат. Этот тип нейросетей обычно используется для прогнозирования, распознавания образов, сжатия массивов данных.

Внимание к деталям

Когда Хопфилд опубликовал свою статью об ассоциативной памяти, Джеффри Хинтон работал в Университете Карнеги-Меллона в Питтсбурге. Ранее он изучал экспериментальную психологию и задавался вопросом, могут ли машины научиться находить закономерности аналогично людям. Хинтон решил использовать сеть Хопфилда в качестве основы для новой нейросети, использующей другой метод: машину Больцмана. Это позволило бы ей автономно находить свойства в данных и выполнять такие задачи, как идентификация определенных элементов на изображениях. Хинтон использовал инструменты статистической физики. Она описывает системы, состоящие из множества одинаковых элементов, например молекул газа.

Их невозможно отследить по-отдельности, но можно рассматривать в совокупности, чтобы определить общие свойства газа, такие как давление или температуру.

Метод «машины Больцмана» еще в 19 веке описал австрийский физик Людвиг Больцман. Она способна предугадывать наиболее вероятные физические состояния системы. По сути, это рекуррентная нейронная сеть, которая обрабатывает видимые и скрытые узлы нейросети, выступающие в роли весов, и определяет вероятности значений, при которых структура узлов может измениться, но свойства сети останутся прежними. Машина Больцмана может учиться — не на инструкциях, а на примерах путем обновления значений в узлах. Обученная машина способна распознавать знакомые паттерны в новой информации, если она относится к категории уже изученной.

Хинтон с коллегами разработал метод предварительного обучения нейросети с помощью серии машин Больцмана по слоям, один поверх другого. Он использовал ограниченные машины Больцмана, в которых нет никаких связей между узлами в одном слое. После обучения первой содержимое скрытых узлов используются для ввода на следующей. Это позволило обучить нейросеть распознавать элементы на картинках. В 2012 году команда Хинтона победила на конкурсе ImageNet, участники которого должны были создать системы компьютерного зрения, способные распознавать 1000 объектов — от животных до ландшафтов и людей.

Таким образом, Хинтон заложил основу для глубокого обучения нейросетей, увеличив число скрытых слоев в них. Глубокое обучение позволяет создавать более сложные ИИ-системы, способные решать различные задачи — машинного перевода, компьютерного зрения, синтеза и распознавания речи.

Делайте «Новую» вместе с нами!

В России введена военная цензура. Независимая журналистика под запретом. В этих условиях делать расследования из России и о России становится не просто сложнее, но и опаснее. Но мы продолжаем работу, потому что знаем, что наши читатели остаются свободными людьми. «Новая газета Европа» отчитывается только перед вами и зависит только от вас. Помогите нам оставаться антидотом от диктатуры — поддержите нас деньгами.

Нажимая кнопку «Поддержать», вы соглашаетесь с правилами обработки персональных данных.

Если вы захотите отписаться от регулярного пожертвования, напишите нам на почту: [email protected]

Если вы находитесь в России или имеете российское гражданство и собираетесь посещать страну, законы запрещают вам делать пожертвования «Новой-Европа».