Искусственный интеллект одновременно упростил работу политиков и сделал ее невозможной. С одной стороны, кандидаты могут общаться с избирателями на любых языках, но с другой — теперь им приходится постоянно опровергать заявления дипфейков, созданных конкурентами. Научный журналист и автор телеграм-канала «Лайфлонг муки» Илья Кабанов разбирается, как искусственный интеллект влияет на политику.

Британский чат-бот

Технологическая революция, о которой так долго говорили проповедники искусственного интеллекта, откладывается. Единственный ИИ-кандидат на прошедших в Британии в начале июля парламентских выборах разгромно проиграл, заняв в своем округе последнее место.

На первый взгляд, AI Steve выглядел идеальным кандидатом для уставшего от традиционных политиков электората: он всегда был доступен и открыт к общению с избирателями, ему можно было задать любой вопрос и получить более-менее осмысленный ответ.

Строго говоря, AI Steve — это чат-бот, с помощью которого реальный кандидат Стив Эндакот вел свою кампанию. При этом в бюллетенях Эндакот был представлен именно своим виртуальным альтер-эго — британские законы позволяют это. В случае победы он обещал собирать с помощью чат-бота идеи от избирателей и голосовать в парламенте так, как они скажут.

Этот эксперимент в области прямой демократии не нашел отклика у электората: за AI Steve проголосовали 179 человек (победившая на округе представительница партии зеленых набрала почти тридцать тысяч голосов). Впрочем, Эндакот вряд ли всерьез рассчитывал на успех: его электронная версия выглядела нарочито искусственно, в духе ранних опытов в области компьютерной анимации, а система распознавания речи плохо справлялась с региональными британскими акцентами. Кроме того, политик-инноватор не пытался ввести избирателей в заблуждение: общаясь с чат-ботом, сложно было принять его за живого человека.

В других избирательных кампаниях последствия внедрения искусственного интеллекта оказываются гораздо серьезнее, а людям всё сложнее отличать реальных политиков от фейковых.

Роботы опасные и полезные

Опрос, проведенный в 2023 году Институтом Алана Тьюринга совместно с Институтом Ады Лавлейс, показал, что британцы положительно оценивают применение искусственного интеллекта в медицине и образовании, но негативно относятся к его использованию в таргетированной политической рекламе. Более того, респонденты называют ИИ в политике более опасным явлением, чем беспилотные автомобили и боевые дроны.

События последних лет показывают, что такие страхи небеспочвенны. Хотя искусственный интеллект пока, кажется, ни разу не определил исход голосования, политтехнологи всё чаще обращаются к генеративному ИИ и созданию дипфейков, чтобы выставить своих клиентов в выгодном свете и очернить конкурентов.

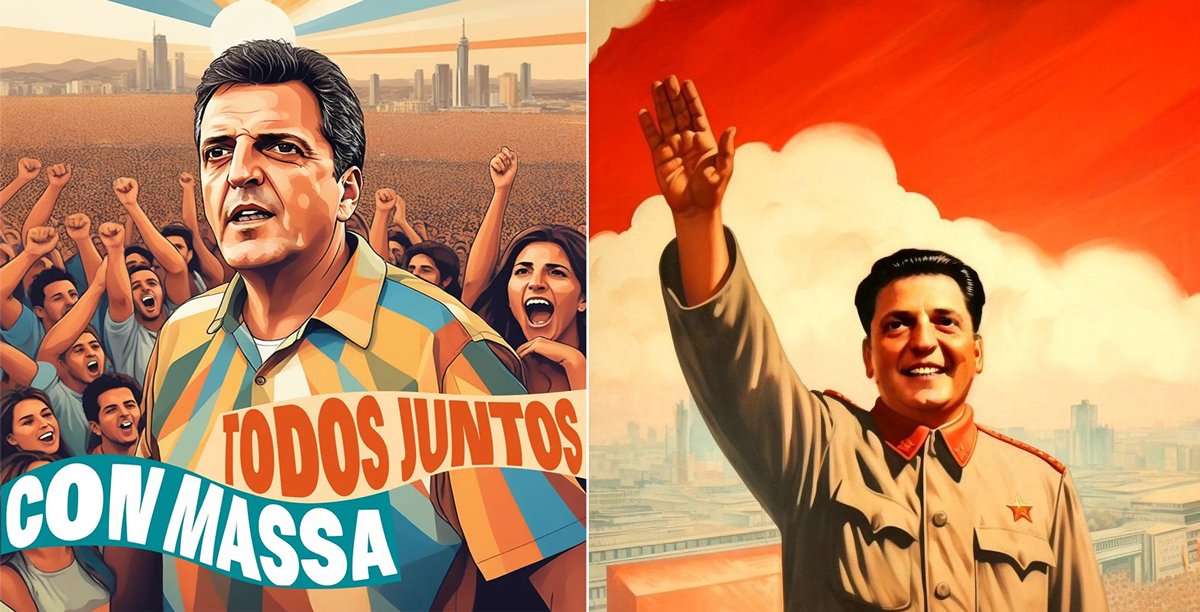

Прошлогодние президентские выборы в Аргентине некоторые журналисты назвали «первой ИИ-кампанией в истории». Штабы основных кандидатов не стеснялись применять генеративные ИИ-инструменты. К примеру, левый министр экономики Серхио Масса использовал созданные искусственным интеллектом иллюстрации в духе соцреализма, а его оппонент-либертарианец — и будущий победитель — Хавьер Милей в ответ изобразил конкурента в образе Мао Цзедуна.

На этом обмен любезностями с привлечением генеративного ИИ не закончился: Масса опубликовал дипфейк-видео, в котором Милей оказался маниакальным героем «Заводного апельсина» (продолжая «голливудский» тренд, сам министр предстал перед электоратом в роли охотника за привидениями — призраком был, разумеется, его оппонент). В гораздо менее невинном дипфейк-ролике штаб Массы изобразил Милея поддерживающим легализацию торговли человеческими органами.

В феврале 2024 года бывший премьер-министр Пакистана Имран Хан выступил с обращением к нации, объявив о победе своей партии на парламентских выборах. По словам Хана, его сторонники получили две трети голосов.

С обращением бывшего премьера было две проблемы. Во-первых, по официальным данным, его партия набрала не две трети, а треть голосов, хотя и получила больше мест в парламенте, чем конкуренты. Во-вторых, Имран Хан не записывал видео, поскольку с мая 2023 года находился под арестом. Вместо него выступал цифровой аватар, созданный искусственным интеллектом. Точно такие же дипфейки агитировали за партию Хана во время предвыборной кампании. Обычно дипфейки обманывают избирателей, но в Пакистане всё было честно. Голосовавшие за партию жители страны понимали, что ее лидер сидит в тюрьме, а для самого Хана дипфейки стали удобным способом донесения своих идей до публики.

В соседней Индии политтехнологи пошли еще дальше. С помощью искусственного интеллекта там «оживили» активистку, погибшую почти полтора десятилетия назад, а оппозиционная партия Индийский национальный конгресс использовала дипфейки звезд Болливуда без их согласия. Правящая партия БДП тоже внедряла новые технологии: премьер-министр Нарендра Моди обращался к избирателям по имени, а его речи автоматически дублировались с хинди на другие распространенные в Индии языки.

Перевод политических заявлений на понятные электорату языки — один из немногих позитивных примеров применения ИИ в политике. Его постепенно начинают внедрять во всём мире: например, мэрия Нью-Йорка использовала технологию VALL-E X, разработанную Microsoft, чтобы дублировать обращения мэра Эрика Адамса. Теперь градоначальник может общаться с нью-йоркцами на идиш и китайском — на языках, которыми он не владеет.

Применение ИИ в политике принимает порой почти комедийные формы. В апреле французская ультраправая партия «Национальное объединение» проголосовала против законопроекта, запрещающего публикацию дипфейков без согласия людей, которые в них фигурируют. Вскоре руководство партии само стало жертвой такой атаки: накануне выборов в Европарламент в соцсетях появились ролики, в которых несуществующие родственницы бывшей руководительницы партии Марин Ле Пен издеваются над национальными меньшинствами.

Джо Байден. Фото: Jim Lo Scalzo / EPA-EFE

Знакомые голоса

Но, пожалуй, самые важные выборы 2024 года — это президентская кампания в США. Она точно войдет в историю как одна из самых насыщенных событиями: один из кандидатов пережил покушение, другой снялся с выборов. Не обошлось и без искусственного интеллекта.

В январе перед праймериз в Нью-Гемпшире избиратели начали получать автоматические телефонные звонки якобы от президента Джо Байдена с призывом не участвовать в голосовании. Участие в праймериз Демократической партии поможет кандидату-республиканцу Дональду Трампу победить на всеобщих выборах в ноябре, парадоксально утверждал «президент» (разумеется, это не так). Хотя голос был похож на президентский, шутникам (или злоумышленникам) не удалось перехитрить жителей штата: Байден набрал 64% голосов, хотя официально даже не был кандидатом — избиратели просто вписывали его имя в бюллетени.

Быстро выяснилось, что дипфейк-запись была сгенерирована с помощью технологий стартапа ElevenLabs, который специализируется на «клонировании» голосов реальных людей с помощью искусственного интеллекта. Компания заблокировала аккаунт пользователя, пытавшегося ввести в заблуждение избирателей.

Инцидент стал поводом усилить защиту от вмешательства дипфейков в политические процессы. В середине июля основатели ElevenLabs заявили, что ввели автоматическую блокировку голосов политических деятелей и создали инструмент, который определяет, был ли сгенерирован образец речи.

Одновременно стартаперы рассказали о позитивном кейсе внедрения ИИ в политику: компания «клонировала» голос конгрессвумен Дженнифер Векстен, потерявшей способность говорить из-за болезни. Она уже использовала свой новый цифровой голос на заседании комитета Конгресса. Вероятно,

такие случаи не нарушают правила о блокировке голосов политиков, что еще раз подчеркивает, как сложно регулировать быстроразвивающуюся отрасль.

Конечно, клонированием голосов сфера применения ИИ в американской политике не ограничивается. Весной журналисты заметили, что в попытке привлечь голоса афроамериканцев сторонники Трампа распространяют сгенерированные изображения чернокожих избирателей, якобы поддерживающих бывшего президента.

Уже после того как Джо Байден отказался от участия в президентских выборах, уступив место вице-президентке Камале Харрис, он вновь стал жертвой дипфейков. Аккаунты сторонников теорий заговоров начали распространять сфабрикованный скриншот новости CNN с двумя изображениями Байдена в больнице, сгенерированными ИИ: якобы президент находится в госпитале. Кроме того, в конце июля миллиардер Илон Маск поделился в твиттере роликом, в котором сгенерированный ИИ голос Камалы Харрис был наложен на реальное видео ее выступления.

Российские политики не смогли пройти мимо всеобщего увлечения дипфейками. Летом 2023 года руководители ЛДПР сначала представили «виртуального Жириновского», а затем выпустили чат-бот в телеграме на основе нейросети, обученных на речах умершего в 2022 году лидера партии.

В свою очередь, Владимир Путин на одной из пресс-конференций пообщался с собственным дипфейком. При этом прокремлевские аналитики не зафиксировали случаев использования дипфейков на прошедших в 2024 году президентских выборах. Это не помешало Верховному суду превентивно выпустить постановление, которое приравнивает дипфейки в предвыборной кампании к нарушению правил агитации и грозит многотысячными штрафами.

Судя по всему, российские политтехнологи предпочитают использовать нейросети для вмешательства в выборы в других странах. В частности, их обвиняли в раскрутке дипфейков в Молдове и Словакии.

Картонная фигура Владимира Путина у витрины сувенирного магазина в центре Москвы, 14 ноября 2023 года. Фото: Максим Шипенков / EPA-EFE

Как защититься от дипфейков

Хорошая новость в том, что пока технологии создания фальшивых видео и изображений неидеальны. На первый взгляд дипфейки выглядят реалистично, но при внимательном изучении легко заметить артефакты и следы манипуляций.

Эксперты выделяют несколько элементов, на которые стоит обращать внимание:

- Несоответствия в области рта и подбородка. В фейковых видео кожа вокруг рта часто выглядит менее детализированной, а контуры подбородка могут быть размыты. Кроме того, можно заметить рассинхронизацию голоса и движений губ.

- Плохое качество видео. Низкое разрешение и следы монтажных склеек могут быть признаком дипфейка.

- Проблемы с головой и телом. Неестественные движения, неправильная форма ушей, несоразмерность головы телу и различия в тоне кожи на шее и лице должны вызвать подозрения.

- Изменения в одежде. Видео, где галстук и рубашка персонажа в процессе меняют цвет, — явный признак манипуляции.

- Лишние пальцы или конечности. На изображениях, созданных ИИ, у людей могут быть лишние пальцы или неестественно выглядящие руки.

- Странные буквы и цифры. Нейросети пока плохо справляются с генерацией надписей, поэтому нужно уделять внимание табличкам, плакатам и другим текстам в изображениях.

По мере совершенствования алгоритмов нейросетей эти советы станут менее надежными, поэтому останется только рассчитывать на свой здравый смысл и надеяться на появление технических средств, способных распознавать дипфейки, а также на всеобщее регулирование этой сферы.

Делайте «Новую» вместе с нами!

В России введена военная цензура. Независимая журналистика под запретом. В этих условиях делать расследования из России и о России становится не просто сложнее, но и опаснее. Но мы продолжаем работу, потому что знаем, что наши читатели остаются свободными людьми. «Новая газета Европа» отчитывается только перед вами и зависит только от вас. Помогите нам оставаться антидотом от диктатуры — поддержите нас деньгами.

Нажимая кнопку «Поддержать», вы соглашаетесь с правилами обработки персональных данных.

Если вы захотите отписаться от регулярного пожертвования, напишите нам на почту: [email protected]

Если вы находитесь в России или имеете российское гражданство и собираетесь посещать страну, законы запрещают вам делать пожертвования «Новой-Европа».