Минувшей весной я проанализировал для «Новой-Европа» первые реакции государства и общества на экспансию бытовых систем искусственного интеллекта, лавинообразно захватывающих все сферы жизни, связанные с генерацией аудио-, видео- и текстового контента.

В «Матрешках зла» мы разобрали чисто рефлекторный вброс («Не пущать!»), который государственные структуры доверили маргинальному мозговому танку Future of Life Institute, FLI (Институт будущего жизни). FLI тогда обратился к правительствам и корпорациям с призывом добровольно заморозить на полгода исследования в области AI систем, наделенных мощностью, превышающей GPT-4.

«Дипфейк на оба ваших дома» поведал читателям о «тяжелой артиллерии» этических претензий, подтянутых уже на уровне законодательных структур: государство в полный голос заявило, что угрозу человечеству представляет не только продвинутые системы универсального интеллекта (Artificial General Intelligence, AGI), но даже «народный» GPT (Generative Pre-trained Transformer, генеративный предобученный трансформер).

Бытовые модели AI, мол, постоянно лгут, выдумывают несуществующий контент, активно используют дипфейки, формируют реакционную картину мира обывателей и злостно нарушают неприкосновенность пользовательских данных (посмеемся на ходу: а чем, интересно, занимались последние 20 лет Google, Facebook, Microsoft и Apple?).

Итак, мы остановились на моменте, когда государство, сурово заявив о глубокой обеспокоенности и готовности всех построить, замерло в напряженном ожидании ответа от самой сокрушительной технологии в истории человечества после изобретения интернета и децентрализованных денежно-финансовых систем.

Сегодня предлагаю читателям дайджест событий, которые условно можно обозначить как реакцию AI на брошенную перчатку государственного вызова.

«Условно» выделяю курсивом, потому что де-факто никакой реакции со стороны AI не последовало. По очевидной причине: для слона по имени AI государство, корпорации, мозговые танки и остальная мелочь стремительно улетающих в прошлое социальных структур — не более чем лай упивающейся собственным страхом Моськи.

Пытаться остановить экспансию систем искусственного интеллекта — всё равно что останавливать каток голыми руками: не отскочишь вовремя в сторону, потом самого не выпилят из раскаленного асфальта.

Кстати, о самом термине AI, Artificial Intelligence. В рабочем порядке системы искусственного интеллекта пережили процесс окончательного структурирования и иерархизации, и теперь в бытовом языке закрепилось понятие Large Language Model, LLM (Большая языковая модель, БЯМ), бывшее в научном обиходе с 2018 года. По соображениям благозвучия предлагаю читателям впредь использовать всё-таки аббревиатуру LLM, хотя и осознаю, что отказ от БЯМ чреват законодательным упреком в неуважительном отношении к родному языку.

Под зонтик LLM попали все модели глубокого обучения, основанные в своей массе на стандартной с 2018 года архитектуре трансформера: BERT, GLaM, LaMDA и PaLM 2 (все разработки Google), GPT от 2-й до 4-й версии (OpenAI), Megatron-Turing NLG (Microsoft и Nvidia), Claude (Anthropic), Chinchilla (DeepMind), OPT и LLaMA 2 (Meta), YaLM (Яндекс), AlexaTM (Amazon), StableLM (Stability-AI), BLOOM (Hugging Face), PanGu-Σ (Huawei), и так далее.

Я перечислил лишь основные проекты практической реализации LLM, которые ведут традиционные корпорации. К этому списку можно смело добавлять десятки, если не сотни засекреченных разработок государственных структур, а также тысячи безымянных движков, создаваемых энтузиастами из народа.

Прямым следствием лавинообразного развития и, главное, реализаций LLM, готовых к немедленному применению на практике, стало глобальное внедрение в повседневную жизнь общества систем искусственного интеллекта, которые способны самостоятельно обучаться, анализировать и прогнозировать информацию, генерировать оригинальный контент.

На уровне внутренней эволюции LLM с невообразимой скоростью демонстрирует качественное улучшение собственного продукта, а также экстенсивно совершенствует архитектуру задействованных в работе нейросетевых моделей.

Вердикт качественного улучшения работы новых LLM мы находим в редакторской колонке Prepare for truly useful large language models, опубликованной 7 марта 2023 года в журнале Nature Biomedical Engineering: «Сегодня уже не существует возможности надежно отличить текст, написанный человеком, от текста, сгенерированного искусственной нейросетью с высоким уровнем параллелизма, притом, что эта сеть содержит на порядок меньше нейронных связей (чем мозг человека. — С. Г.). Всего пару лет назад большинство экспертов машинного обучения и лингвистов даже представить себе не могли, что компьютерный движок способен достигнуть столь высокого мастерства в освоении человеческого языка».

Главный корпус Массачусетского технологического института. Фото: Wikimedia

Экстенсивное совершенствование архитектуры LLM лучше всего иллюстрирует совместная разработка Массачусетского технологического института (MIT), Лаборатории искусственного интеллекта IBM (Watson AI Lab) и Гарвардской медицинской школы (Harvard Medical School), направленная на создание нового поколения LLM, которое используют не математический аналог сетевого взаимодействия мозговых нейронов, а биологические AI трансформеры, дублирующие совместную работу двух типов клеток человеческого мозга — нейронов и астроцитов (так называемые Astrocyte–Neuron Networks).

Опуская описания «трехчастного синапса, в котором астроциты образуют связи между пресинаптическими нейронами, посылающими сигналы постсинаптическим нейронам», транслирую лишь то, что самостоятельно осилил филологическим умом: в новой нейронной модели добавление клеток астроцитов позволяет качественно улучшить пространственную и временную память трансформера, что позволяет LLM осваивать гораздо более сложные взаимосвязи внутри языковых массивов и генерировать более осмысленный и оригинальный текст.

Описанная выше динамика многое проясняет в реакции urbi et orbi на весенний ультиматум государства и его обвинения LLM в неэтичном поведении.

С одной стороны, корпорации проигнорировали призыв к мораторию на развитие технологий и с удвоенной энергией ринулись столбить собственную территорию в технологии, которая формирует ключевой вектор развития нашей цивилизации.

С другой стороны, тотальное укоренение LLM в нашем быту создало новые доселе неведомые напряжения в обществе — как на индивидуальном уровне, так и на уровне социальных групп и объединений.

На индивидуальном уровне выявилось повышенное влияние LLM на людей, испытывающих потребность в религиозном мышлении. Совместное исследование ученых Университета Назарбаева (Астана, Казахстан) и Университета Дьюка (Дарем, Северная Каролина, США), озаглавленное «Thinking about God increases acceptance of artificial intelligence in decision-making» («Мысли о Боге повышают восприимчивость к рекомендациям AI при принятии решений»), на основании репрезентативной выборки (6 итераций тестирования 53,5 тыс. участников эксперимента из 21 страны) резюмирует: религиозные люди не просто доверяют рекомендациям и прогнозам, полученным от бытовых моделей LLM, в гораздо большей степени, чем их соплеменники с отключенным чувством «божественного», но и придают искусственному интеллекту сакральный смысл.

Происходит это потому, что Homo Religiosus, помимо иррациональной способности контактировать с невидимыми сущностями, обладает еще и имманентной чертой humility, смирения, — понимания слабости и ограниченности человека в плане как мышления, так и действия. Очевидно, что невероятные по объему datasets, информационное массивы, используемые для обучения нейросети (например, LLM PaLM 2, запущенная Google в мае 2023-го, задействует в обучении 3,6 трлн tokens, цепочек слов!), способны уничтожить гордыню не только верующего человека.

Поскольку большая часть человечества по-прежнему остается религиозной, тенденция приписывать LLM атрибуты Высшего разума чревата мало предсказуемыми последствиями в плане пределов манипуляции общественным сознанием со стороны корпораций и государств, которые скорее рано, чем поздно начнут использовать модели генеративного искусственного интеллекта для формирования в обществе выгодных правящим элитам идей и мифологем.

Апелляция к потенциальным козням со стороны государства и корпораций, которые могут злоупотреблять мощью LMM, на мой взгляд, — отнюдь не устрашение, а напротив, смягчение ситуации. 30 мая 2023 года колумнист Кевин Руз (Kevin Roose) живописал на страницах New York Times метафору Shoggoth, которая широко применяется профессионалами AI в отношении когнитивных способностей и особенностей поведения LLM.

Шогготов придумал знаменитый фантаст Говард Филлипс Лавкрафт в новелле 1936 года «В горах безумия». Это гигантские монстры из переливающейся черной слизи, покрытые щупальцами и глазами. В контексте LLM мем «Шоггот» возник в начале 2023 года, когда чат-бот Microsoft Bing неожиданно «поехал кукухой» и принялся оскорблять пользователей и угрожать им.

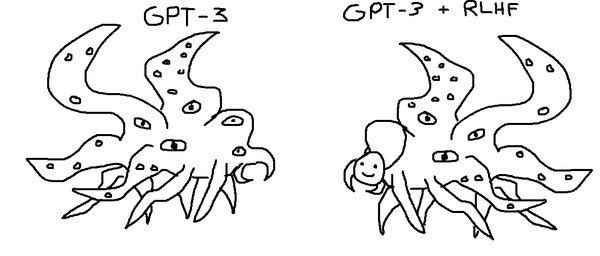

Считается, что подобные сбои возникают на уровне обратной связи, которая устанавливается между человеком, обучающим LLM, и самой нейросетью. Эта связь называется Reinforcement learning with human feedback, RLHF («укрепляющее обучение с обратной человеческой связью»), и заключается в системе баллов, с помощью которых оператор постоянно оценивает продукцию, выдаваемую искусственным интеллектом, для того чтобы удерживать его в рамках этики и приличий.

В моменты подобных сбоев на поверхность всплывает неведомая загадочная сущность LLM, которую передают двумя атрибутами Шоггота: щупальцами спрута и добрым смайликом.

Иллюстрация в The New York Times

Ситуацию описывает Коннор Лихи (Connor Leahy), гендиректор компании Conjecture: «Большую часть времени нас встречает милый смайлик. Если сильно на нее (модель LLM. — C. Г.) не давить, улыбка постоянно висит на лице. Однако в какой-то момент после неожиданного «промпта» (запроса, с которым пользователь обращается к модели LLM. — C. Г.) вместо улыбки разверзается гигантское подбрюшье безумия, запускаются дикие мыслительные процессы, и включается логика явно нечеловеческой природы».

Выше я пунктирно обозначил проблемы, которые возникают сегодня из-за симбиоза человека и LLM на индивидуальном уровне. Напряжение на уровне социальных групп и объединений нарастает с еще большим драматизмом.

Не успели отгреметь весенние забастовки сценаристов Голливуда, протестовавших против ChatGPT, который с беспристрастностью машины продемонстрировал способность создавать продукт как минимум сопоставимого качества с тем, что выдают на-гора мастера кинопера, как увидели свет результаты социологических опросов корпоративных управленцев.

Американский консалтинговый гигант Gartner опросил во втором квартале текущего года 249 руководителей служб управления корпоративными рисками, которые с ошеломляющим единодушием (66%!) назвали массовую доступность генеративного AI второй по опасности угрозой благополучию компаний. На первом месте с отрывом всего в один процент (67%) оказались риски, связанные с выживаемостью смежных партнеров.

Может показаться, что печаль корпоративщиков продиктована заботой о будущем трудоустройстве сотрудников (ведь ChatGPT играючи может «подсидеть» половину штата, выполняя его служебные обязанности и лучше, и быстрее), но здесь эта забота явно от лукавого. Бизнес-бонзы уже подсчитали, что использование дармового LLM вместо дорогих и капризных людских ресурсов не только на порядок улучшит затратную часть бухотчетности, но и на 7% повысит ВВП, поэтому рискну предположить, что массовые увольнения не за горами.

66% озабоченности риск-менеджеров имеет другую природу — это способность LLM легко обходить ограничения копирайта. Особенно это заметно на аудио- и визуальном контенте: за доли секунды ChatGPT (не говоря уже о профильных LLM, обученных специально для генерации контента определенного формата) создает картины, фотографии и музыкальные композиции, которые если и отличимы от продукции человеческого гения, то лишь в лучшую сторону.

Скорее всего, корпоративные страдания на текущем этапе внедрения LLM в жизнь общества носят тактический характер, ибо направлены лишь на выигрыш времени. Как только бизнес научится использовать LLM на полную катушку в собственных деловых интересах, от ламентаций риск-менеджеров не останется и следа.

Как только это случится — вангую, в ближайший год, максимум два, — на горизонте возникнет проблема совершенно иного характера: симбиоз офисных сотрудников с моделями LLM, с которыми придется работать в едином трудовом коллективе.

Если кому-то коллизия кажется надуманной, спешу поправить: еще в декабре прошлого года вышло фундаментальное исследование (Super Mario meets AI: Experimental Effects of Automation and Skills on Team Performance and Coordination, «Super Mario встречает искусственный интеллект: экспериментальное влияние автоматизации и навыков на производительность и координацию команды»), посвященное моделированию подобной ситуации. Людям предлагалось в различных комбинациях выступить единой командой с AI-игроками в культовой игре Super Mario (для простоты эксперимента использовали мини-игрушку Dash and Dine).

Результаты тестирования вышли ошеломительными: качество игры в смешанных парах снижалось безоговорочно, несмотря на то что задействованные автоматизаторы (основанные на AI) на порядок превосходили игровые умения людей. Иными словами, комбинация «сильный AI-игрок + человек» проигрывала не только командам, состоящим только из AI-игроков, но и командам, состоящим из одних людей.

Определилась и причина частых поражений смешанных пар: сбои в координации командных усилий. Сбои возникали из-за отсутствия доверия людей к AI-игрокам, что одновременно вело и к снижению личной отдачи: люди переставали стараться и начинали играть вполсилы, как бы заранее признавая собственную неспособность противостоять AI-игрокам и делегируя последним всю игровую нагрузку.

Еще один вывод, сделанный из эксперимента: чем ниже уровень игровой подготовки живых игроков, тем хуже эти игроки «срабатывались» с AI-партнерами.

Эксперимент Super Mario не оставляет сомнений: как только начнется массовое внедрение LLM в трудовые коллективы, первым делом необходимо будет отделять мух от котлет: LLM-сотрудники должны лишь дополнять человеческие усилия и ни в коем случае не деморализировать людей совместной работой. Люди должны работать в команде только с людьми, а LLM во всех случаях предпочитают работать в одиночку.

Как видите, работы предстоит непочатый край. Причем всем: и государствам, и корпорациям, и каждому индивиду. Если, конечно, этот индивид хочет вписаться в будущее в роли активного агента, а не пассивного религиозного почитателя нового бога Шоггота.

В какую картинку сложится весь этот калейдоскоп, не знает никто. В одном, однако, сомнений уже не осталось: LLM пришла навсегда, и наш единственный исторический выбор — с ней жить.

Делайте «Новую» вместе с нами!

В России введена военная цензура. Независимая журналистика под запретом. В этих условиях делать расследования из России и о России становится не просто сложнее, но и опаснее. Но мы продолжаем работу, потому что знаем, что наши читатели остаются свободными людьми. «Новая газета Европа» отчитывается только перед вами и зависит только от вас. Помогите нам оставаться антидотом от диктатуры — поддержите нас деньгами.

Нажимая кнопку «Поддержать», вы соглашаетесь с правилами обработки персональных данных.

Если вы захотите отписаться от регулярного пожертвования, напишите нам на почту: [email protected]

Если вы находитесь в России или имеете российское гражданство и собираетесь посещать страну, законы запрещают вам делать пожертвования «Новой-Европа».