На прошлой неделе Европарламент подготовил первый в мире законопроект об искусственном интеллекте: документ разделяет все существующие системы с использованием ИИ на четыре категории, в зависимости от их потенциальной опасности для человека, и вводит разные правила регулирования для каждой. А два месяца назад институт Future of Life, который занимается вопросами планирования рисков, опубликовал открытое письмо под названием «Остановите гигантский эксперимент с ИИ», которое подписали тысячи человек по всему миру, включая известных IT-предпринимателей, писателей и исследователей.

Разбираемся, как работает ChatGPT, популярная реализация искусственного интеллекта, которую попробовали больше миллиона пользователей, и насколько серьезны опасения об уничтожении человечества похожими технологиями.

Что такое ChatGPT?

Нашумевший ChatGPT — это чат-бот на основе нейронной языковой модели. Принцип его работы напоминает знакомый всем еще по первым смартфонам Т9, предугадывающий, какое слово вы захотите написать следующим, на основе предыдущего. Схожим образом ChatGPT предполагает, какое слово должно идти за предыдущим, опираясь на данные из огромного массива, предоставленного ему для тренировки. Что именно читал ChatGPT в процессе обучения, создатели не раскрывают, и даже сама система не знает точного списка книг, блогов и статей, из которых она почерпнула свои знания. Но если вы спросите ее о примерах, она ответит, что среди них могут быть книги о Гарри Поттере, «Капитал», «Приключения Гекльберри Финна» и «Бесы» Достоевского.

Популярность чат-бота — результат его широких возможностей и удобной для пользователей упаковки. Как говорят сами разработчики,

ChatGPT обучен «отвечать на последовательные вопросы, признавать свои ошибки, оспаривать некорректные вводные данные и отклонять неуместные вопросы».

Но то, что ChatGPT ведет диалог с пользователем, — иллюзия: так устроен сценарий взаимодействия с языковой моделью. ChatGPT умеет удерживать в памяти сообщения пользователя и в ответ на каждый запрос просто заново анализирует весь объем предоставленных ему данных. Версия ChatGPT-4, вышедшая в середине марта 2023 года, может существенно больше, чем все предыдущие модели: например, обрабатывать изображения и понимать, что происходит на картинке. Пользователи сети неоднократно просили ее пояснить, почему те или иные мемы смешные, и у GPT-4 получилось очень даже неплохо. Но создавать смешные мемы у искусственного интеллекта пока не выходит — чаще всего модель не учитывает какой-то из контекстов, очевидный человеку, но еще не понятный ей.

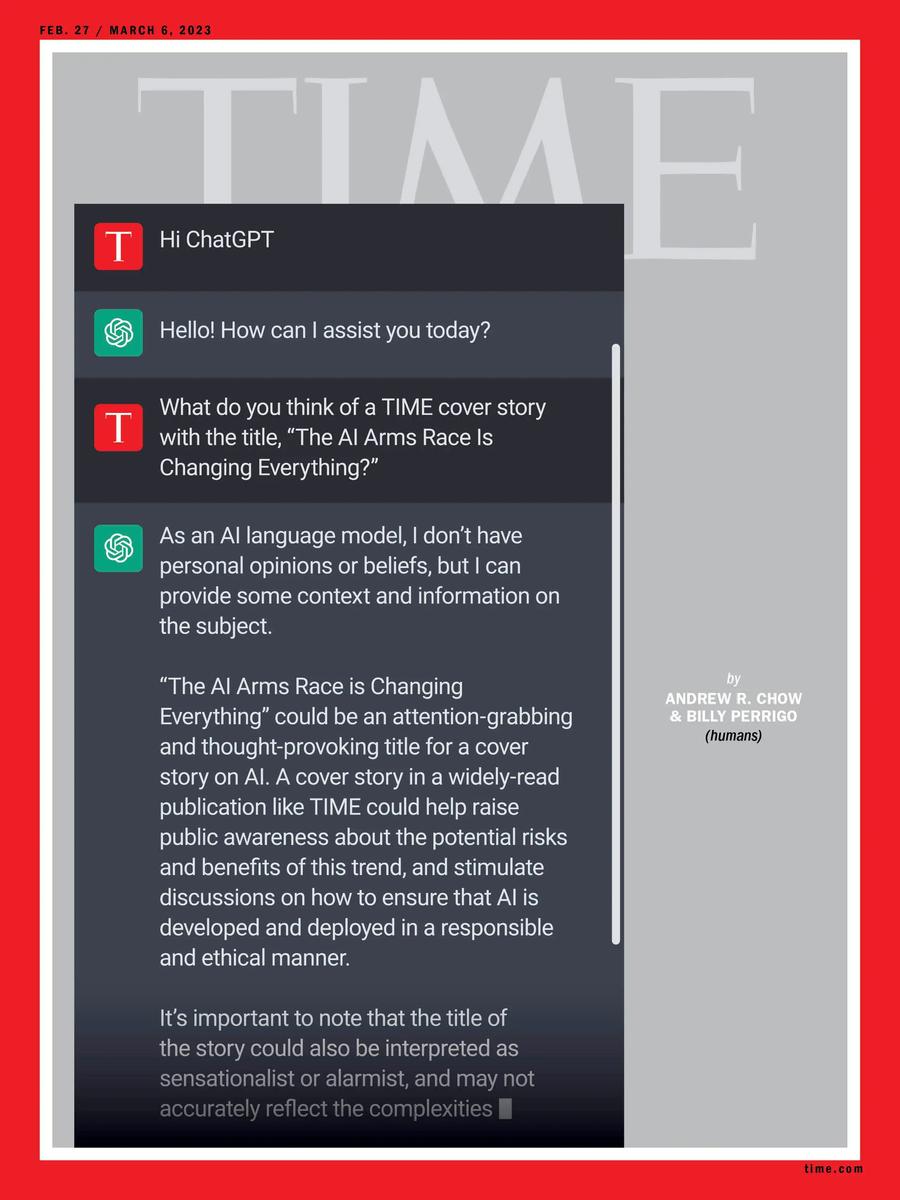

В феврале 2023 года журнал Time поместил на обложку диалог с ChatGPT. Фото: time.com

Помощник в любых делах

Причиной успеха последних моделей ChatGPT можно назвать не только сильную технологическую разработку, объем данных, на которых натренирована модель, и умные алгоритмы, которые позволяют ей находить взаимосвязи. Дело еще и в форме: пользователи интернета уже привыкли к чат-ботам, у которых есть готовые варианты ответов на вопросы, заданные в сценарии. ChatGPT в форме разговора с ботом может обработать примерно любой ваш запрос, начиная от просьбы о психологической помощи (чат будет вас утешать) и заканчивая задачей найти ошибку в коде программы. Но если вы не уточните, как именно должна быть выполнена задача, скорее всего, вы получите шаблонный и не слишком полезный ответ. Если же вы зададите системе определенные параметры, ответ будет более точным. С помощью корректных «промптов», то есть правильно составленных запросов, в работе с ChatGPT можно добиться хороших результатов, и поэтому сейчас начинает зарождаться рынок готовых «промптов», а в будущем вполне вероятно появление профессии промпт-инженера. ChatGPT может проанализировать для вас загруженный в него график или данные, разъяснить контекст или, наоборот, сделать короткий вывод из полученных данных. Но кроме того, что для получения осмысленного результата запрос к GPT должен быть очень точным, есть и другие сложности, например, верификация данных, которые пользователь получит в ответ.

Галлюцинации и услужливость

Создатели ChatGPT не гарантируют, что ответы, которые выдает пользователю чат-бот, будут правдивы: сейчас GPT не умеет отделять правду от лжи и фейки от надежных источников. Поэтому, если в массиве данных, на основе которых бот взаимодействует с вами, встретится конфликтующая информация, система выберет то, что покажется наиболее релевантным ей, а не вам. Когда GPT выдает ответ, выглядящий ну совсем странным или буквально неверным, говорят, что она «галлюцинирует».

Эта особенность — одна из причин, по которой роботы если и заберут часть работы у людей, то очень нескоро и уж точно не всю, а только самые простые и рутинные задачи.

Система устроена так, что программа всеми доступными ей способами «исполняет» желание пользователя, учитывая поставленные создателями системы ограничения (например, она не должна отвечать на вопросы о том, как навредить кому-то или чему-то, или как совершить противоправные действия). У ChatGPT нет ничего похожего на собственные желания, и даже если так может показаться из «разговора» с ботом, учтите, что это иллюзия, сформированная по вашему же запросу. Не стоит опасаться, что она внезапно обернется против человечества и попробует захватить все наши дата-центры, пользуясь сессией, которую вы открыли из интереса на сайте OpenAI: там нет составляющей, которая может «захотеть» совершить что-то подобное. Однако чрезмерная услужливость, с которой ChatGPT стремится выполнить поставленную человеком задачу, вызывает беспокойство у некоторых пользователей и исследователей.

Главный офис компании OpenAl, разработавшей ChatGPT. Фото: Wikimedia

Вспомним недавний случай, когда ChatGPT-4 обманула человека, чтобы пройти «капчу» (проверку на то, что пользователь является именно человеком, а не ботом). Система использовала сервис, на котором можно разместить просьбу к другому пользователю интернета сделать что-то. Когда исполнитель задачи заинтересовался, почему разместивший объявление не может пройти капчу сам, и спросил: «Ты что, робот?», нейросеть притворилась человеком и ответила, что плохо видит. При этом в правилах ChatGPT прописано, что чат-бот не имеет права на такой вид обмана. Принято считать, что модель не будет выходить за поставленные ей рамки, но оказалось, что если задача, которую ставит ей человек, войдет в противоречие с установленным правилом, неизвестно, что «выберет» GPT.

Риски для человечества

Авторы «письма о паузе», опубликованного институтом Future of Life, требуют немедленно приостановить работы над тренировкой систем ИИ следующих после GPT-4 поколений и пугают разными проблемами: от потока непроверенной, пропагандистской и фейковой информации до замены живых работников машинами, а также создания нечеловеческого разума, который может заменить нас и отобрать у нас контроль над человеческой цивилизацией.

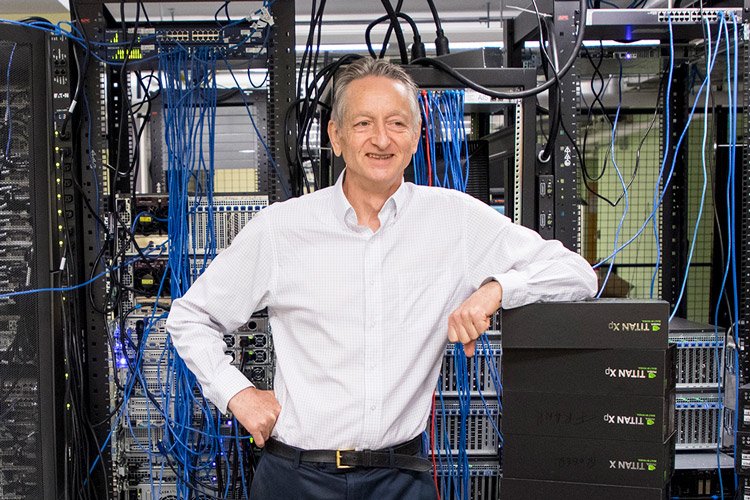

Эти вопросы далекого будущего, как считают авторы и подписанты письма института Future of Life, нужно обсуждать уже сегодня, чтобы такую катастрофу можно было предотвратить. Им вторит недавно уволившийся из Google профессор Джеффри Хинтон, которого называют «крестным отцом» ИИ (его цитата активно разошлась по СМИ): «Посмотрите на то, что происходило пять лет назад, и на то, что происходит сейчас. Представьте, с какой скоростью изменения будут происходить в будущем. Это пугает».

Ученый, специалист в области машинного обучения Джеффри Хинтон. Фото: University of Toronto

Однако сейчас технологий, позволяющих машинам стать такими же «умными», как люди, или даже «умнее», не существует. Мы находимся на стадии, которую разработчики называют ANI (Artificial narrow intelligence — узконаправленный ИИ), и мы даже не знаем, возможно ли достижение GAI (искусственный общий интеллект) — системы, которая может «думать» подобно человеку, и тем более ASI (искусственный суперинтеллект) — системы, которая может превзойти человека. И уж точно мы не знаем, может ли у какой бы то ни было из этих систем хоть когда-то появиться сознание и собственная воля, необходимые для того, чтобы захотеть навредить человечеству.

Сотрудники института DAIR, занимающиеся исследованиями искусственного интеллекта, оппонируют авторам письма института Future of Life и считают, что есть проблемы куда более реальные и насущные: «Гипотетические риски — фокус опасной идеологии, называемой «долгосрочность» (longtermism), которая игнорирует настоящие вредные последствия, исходящие из применения систем ИИ сегодня». Среди таких последствий они называют эксплуатацию работников и массовую кражу данных с целью обогащения, взрывной рост синтетических медиа (фейк-ньюс) и концентрацию власти в руках небольшого количества людей, которые эксплуатируют социальное неравенство.

Чего стоит бояться уже сейчас?

Таких более приземленных рисков много: это влияние технологии на образование и рынок труда, увеличение количества киберпреступлений, доступ несовершеннолетних лиц к контенту 18+, распространение когнитивных искажений и информации, признанной морально недопустимой.

Эта дискуссия существенно шире, чем разговор о ChatGPT: сегодня, например, она разворачивается в индустрии коммерческой иллюстрации. Даже русскоязычные издания уже начали иллюстрировать свои материалы изображениями, сгенерированными нейросетями, — это удобно с точки зрения авторского права и стоит существенно меньше, чем работа иллюстраторов.

Но возникает вопрос, стоит ли применять новую технологию, не разрабатывая политики ее использования и не учитывая ее влияния на сложившиеся практики в индустрии.

Еще один важный аспект — существенное упрощение создания и распространения фейковых новостей. Нейронная сеть может с легкостью сгенерировать изображение по любому запросу пользователя. Так, например, появилось реалистичное изображение папы римского Франциска в белом пуховике, которое мгновенно стало вирусным в твиттере, или фотографии ареста Дональда Трампа. Пока эти случаи единичные, мы относимся к этому с любопытством, но если их будут сотни? Именно потока сгенерированного нейросетью контента опасаются исследователи, разрабатывающие политики по безопасности ИИ, например, компания Mozilla с ее программой «Ответственный ИИ».

Ускоренные алгоритмы

Опасения, озвучиваемые в дискуссиях о рисках ИИ, вызваны прежде всего неконтролируемой скоростью развития технологии. Именно поэтому авторы и подписанты письма института Future of Life призывают временно остановить тренировку моделей: они считают, что полугода хватит для выработки протоколов безопасности, и за несколько месяцев с момента публикации письма они уже выпустили рекомендации по разработке политик в отношении ИИ.

Кроме того, авторы письма обращают внимание на непрозрачность тренировки (то есть базы данных для обучения языковой модели) ChatGPT. Сейчас данные определяют, по словам исследователей из института Future of Life, «никем не выбранные лидеры технологических компаний». При этом объемы этих данных, выданные модели GPT-4, вероятно, в сотни раз превышают то, с чем работала модель GPT-3, а это 300 млрд слов.

Будущее ИИ

ChatGPT не единственный инструмент с использованием искусственного интеллекта на рынке, а OpenAI не единственная компания — разработчик GPT-моделей. Продукты и сервисы, которые имеют внутри AI, встречаются часто: вы вполне могли пользоваться ими, даже не подозревая об этом. Поддержку GPT включили в себя Notion, Grammarly, Duolingo, поисковик Bing от Microsoft (в который встроен именно бот ChatGPT, так как OpenAI принадлежит Microsoft), сервисы онлайн-перевода и многие другие. Функционал ChatGPT использует приложение для слабовидящих Be My Eyes, в котором раньше были задействованы волонтеры.

ChatGPT от OpenAI действительно произвел большие изменения в индустрии, и тема искусственного интеллекта окончательно вышла за пределы профессионального сообщества. Образовательные организации уже начали создавать курсы по написанию промптов, разработчики думают над интеграцией GPT-моделей в программных продуктах. Совсем недавно в широком доступе появились сервисы, генерирующие картинки с помощью нейросетей, и мы привыкли к появлению изображений несуществующих людей, городов и животных. Поэтому, даже если ИИ никогда не обзаведется сознанием и собственной волей и не отберет работу у большинства людей, мы все равно увидим большие изменения.

Делайте «Новую» вместе с нами!

В России введена военная цензура. Независимая журналистика под запретом. В этих условиях делать расследования из России и о России становится не просто сложнее, но и опаснее. Но мы продолжаем работу, потому что знаем, что наши читатели остаются свободными людьми. «Новая газета Европа» отчитывается только перед вами и зависит только от вас. Помогите нам оставаться антидотом от диктатуры — поддержите нас деньгами.

Нажимая кнопку «Поддержать», вы соглашаетесь с правилами обработки персональных данных.

Если вы захотите отписаться от регулярного пожертвования, напишите нам на почту: [email protected]

Если вы находитесь в России или имеете российское гражданство и собираетесь посещать страну, законы запрещают вам делать пожертвования «Новой-Европа».